Estimativa de densidade kernel

Esta página ou se(c)ção precisa ser formatada para o padrão wiki. (Fevereiro de 2014) |

Em Estatística, estimativa de densidade por Kernel (EDK) é uma forma não-paramétrica para estimar a Função densidade de probabilidade (FDP) de uma variável aleatória. Estimativa da densidade por Kernel é um problema fundamental de suavização de dados onde inferências sobre a população são feitas com base em uma amostra de dados finita. Em alguns campos, como o Processamento de sinais e Econometria é também denominado como o método da janela de Parzen-Rosenblatt, devido aos nomes de Emanuel Parzen e Murray Rosenblatt, que são creditados por criá-lo de forma independente em sua forma atual.[1][2]

Definição

[editar | editar código-fonte]Seja (x1, x2, …, xn) uma amostra de uma variável aleatória independente e identicamente distribuída com uma densidade ƒ desconhecida. Estamos interessados em estimar a forma desta função ƒ. A estimativa de densidade por Kernel pode ser feita através da seguinte fórmula:

em que K é um kernel qualquer, como por exemplo a Função de Gauss, e h > 0 é um parâmetro de distância chamado de largura de banda, que controla a influência dos vizinhos em um kernel. Um kernel com índice h é um kernel que já foi escalonado pela largura de banda, e definido como Kh(x) = 1/h K(x/h). Intuitivamente procura-se escolher um valor de h tão pequeno quanto a distribuição dos dados em uma amostra permitem. No entanto, há sempre um compromisso entre o viés da estimativa e sua variância. Mais informações sobre a escolha da largura de banda estão adiante neste artigo.

Uma gama de funções do kernel são regularmente usadas : uniforme , triangular, biweight , triweight , Epanechnikov , normal, e outras. O kernel Epanechnikov é o ideal no sentido de variância mínima,[3] embora a perda de eficiência seja pequena para as funções kernel listadas anteriormente,[4] e devido às suas propriedades matemáticas convenientes, o kernel normal é muitas vezes usado K(x) = φ(x) , onde φ é a função de densidade normal padrão.

A construção de uma estimativa de densidade kernel encontra interpretações em campos fora da estimativa da densidade. Por exemplo , em Termodinâmica, este é equivalente à quantidade de calor gerado quando os kernels de calor ( a solução fundamental para a Equação do calor) são colocados em cada localização de pontos de dados xi . Métodos similares são usados para construir o Laplaciano discreto em nuvens de pontos para manifold learning.

Exemplo

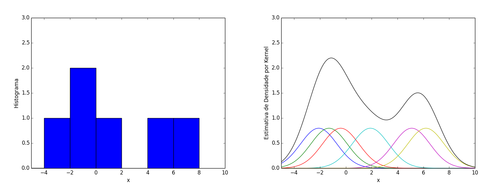

[editar | editar código-fonte]Estimativas de densidade kernel estão intimamente relacionados com os histogramas, mas pode ser dotado de propriedades como suavidade ou continuidade usando um kernel adequado . Para ver isto, nós comparamos a construção do histograma e da estimação de densidade do kernel , usando estes 6 pontos de dados :

| Amostra | 1 | 2 | 3 | 4 | 5 | 6 |

|---|---|---|---|---|---|---|

| Valor | -2.1 | -1.3 | -0.4 | 1.9 | 5.1 | 6.2 |

Para o histograma, o primeiro eixo horizontal é dividido em sub-intervalos ou caixas que cobrem a gama dos dados. Neste caso, temos 6 caixas com largura 2 no intervalo [-6,9]. Sempre que um ponto de dados cai dentro deste intervalo, colocamos uma caixa de altura 1. Se mais do que um ponto de dados cai dentro da mesma caixa, as caixas são empilhadas uma em cima das outras .

Para o cálculo de densidade por Kernel, coloca-se um kernel gaussiano com desvio padrão de 2,5 com média nas abscissas indicadas pelos dados. Os kernels são somados e divididos pelo tamanho da amostra para fazer a estimativa de densidade de kernel (curva preta sólida). A suavidade da estimativa de densidade por kernel é evidente em comparação com a singularidade do histograma, já que as estimativas de densidade de kernel convergem mais rapidamente em direção a verdadeira densidade da população para variáveis aleatórias contínuas.[5]

Seleção de largura de banda

[editar | editar código-fonte]Gráfico[1]

A largura de banda do kernel é um parâmetro livre que apresenta uma forte influência sobre a estimativa resultante. Para ilustrar o seu efeito, vamos dar uma amostra aleatória simulada a partir da distribuição normal (plotados nos pontos azuis na trama tapete no eixo horizontal). A curva de cinza é a verdadeira densidade (a densidade normal com média 0 e variância 1). Em comparação, a curva é pouco suavizada vermelho, uma vez que contém demasiados artefactos de dados espúrios decorrentes da utilização de uma largura de banda h = 0,05 que é muito pequeno. A curva verde é muito suavizada desde usando a largura de banda h = 2 obscurece grande parte da estrutura subjacente. A curva de preto com uma largura de banda de h = 0,337 é considerada para ser perfeitamente alisada desde a sua estimativa da densidade é próxima da densidade verdadeira.

O critério de otimização mais comum usado para selecionar este parâmetro é a função de risco L2 esperado, também denominado a média integrada erro quadrático

Sob premissas fracas sobre ƒ e K,[1][2] MISE (h) = AMISE(h) + o(1/(nh) + h4) onde o é a little o notation. A AMISE é a MISE Assimptótica que consiste em os dois termos principais

Onde para a função g, e ƒ'' é a segunda derivada de ƒ. O mínimo dessa AMISE é a solução para esta equação diferencial.

ou

Nem o AMISE nem as fórmulas hAMISE são capazes de serem usadas diretamente , dado que envolvem a desconhecida função de densidade ƒ ou a sua segunda derivada ƒ'' , de modo que uma variedade de métodos automáticos, à base de dados, foram desenvolvidos para selecionar a largura de banda . Muitos estudos de revisão foram realizados para comparar as suas eficiências[6][7][8][9][10] with the general consensus that the plug-in selectors[11] and cross validation selectors,[12][13][14] com o consenso geral de que o seletores plug-in e seletores de validação cruzada são os mais úteis sobre uma vasta gama de conjuntos de dados .

Substituindo qualquer largura de banda h que tem a mesma ordem assintótican−1/5 por hAMISE na AMISE que dá AMISE ( h ) = O (n -4 /5) , em que S é a grande o notação . Pode ser mostrado que , com base em hipóteses fracas , não pode existir um estimador não paramétrico que converge a uma taxa mais rápida do que o estimador de kernel.[15] Note-se que a taxa de n- 4/5 é mais lento do que o normal n- 1 convergência taxa de métodos paramétricos .

Se a largura de banda não é mantida fixa, mas é variável dependendo da localização da estimativa ( estimador de balão ) ou das amostras ( pontual estimador ), este produz um método particularmente eficaz denominado adaptativa ou estimativa de densidade de kernel de largura de banda variável.

Estimativa prática da largura de banda

[editar | editar código-fonte]Se funções de base gaussianas são usados para aproximar dados univariados, e a densidade a ser estimada é de base gaussiana, então ele pode ser mostrado que a escolha ideal para h é[16]

Onde é o desvio padrão das amostras Essa aproximação é chamado de aproximação normal de distribuição, a aproximação de Gauss, ou regra de Silverman's.

Relação com a função característica do estimador de densidade

[editar | editar código-fonte]Dada a amostra (x1, x2, …, xn) é natural estimar a função característica φ(t) = E[eitX] como

Conhecendo a função característica, é possível encontrar a função de densidade de probabilidade correspondente através da inversa da transformada de Fourier. Uma dificuldade com a aplicação desta fórmula é que ele leva a um integral divergente uma vez que a estimativa não é confiável para t’s grandes. Para contornar este problema, o estimador de é multiplicado por uma função de amortecimentoψh(t) = ψ(ht), que é igual a 1, na origem, e, em seguida, cai para 0 até ao infinito. O parâmetro "largura de banda" h controla quão rápido vamos tentar amortecer a função . Em particular, quando h é pequena, então ψh(t) irá ser cerca de um para um grande intervalo de t’s, o que significa que permanece praticamente inalterada na região mais importante de oft’s.

A escolha mais comum para a função ψ ou é a função uniforme ψ(t) = 1{−1 ≤ t ≤ 1}, o que efetivamente significa truncar o intervalo de integração na fórmula de inversão para [−1/h, 1/h], ou o função gaussiana ψ(t) = e−π t2. Uma vez que a função ψ tenha sido escolhido, a fórmula de inversão pode ser aplicada, e o estimador de densidade será

Onde K é a transformada inversa de fourier da função de amortecimento ψ. Assim, o estimador de densidade de kernel coincide com o estimador de densidade da função característica.

Implementação estatística

[editar | editar código-fonte]Implementação em MATLAB-Octave

[editar | editar código-fonte]Para este exemplo, os dados são de uma amostra de 50 pontos sintéticos desenhados a partir da normal padrão e 50 pontos a partir de uma distribuição normal com média de 3.5 e variância 1. A seleção automática da largura de banda e a estimação da densidade com kernels normais é realizada por kde.m

randn('seed',8192);

x = [randn(50,1); randn(50,1)+3.5];

[h, fhat, xgrid] = kde(x, 401);

figure;

hold on;

plot(xgrid, fhat, 'linewidth', 2, 'color', 'black');

plot(x, zeros(100,1), 'b+');

xlabel('x')

ylabel('Density function')

hold off;

Implementação em R

[editar | editar código-fonte]Este exemplo é baseado no Old Faithful , uma atração turística localizada no parque nacional de Yellowstone. Este conjunto de dados famoso contendo 272 registros consiste em duas variáveis, duração erupção , e tempo de espera até a próxima erupção, tanto em questão de minutos , incluído na distribuição base do R. Analisamos os tempos de espera , utilizando a biblioteca ks uma vez que tem uma ampla gama de opções de visualização . A função de largura de banda é hpi, que por sua vez chama a função dpik na biblioteca KernSmooth: estas funções implementam o plug-in seletor.[11] a densidade kernel estimada usando o kernel normal é calculado usando kde que chama bkde de KernSmooth. O função plot permite a adição de pontos de dados como uma trama de tapete no eixo horizontal. A estrutura bimodal na estimativa da densidade dos tempos de espera pode ser visto claramente , em contraste com o "terreno de tapete" onde esta estrutura não é aparente .

library(KernSmooth)

attach(faithful)

fhat <- bkde(x=waiting)

plot (fhat, xlab="x", ylab="Density function")

Referências

- ↑ a b Rosenblatt, Murray (1 de setembro de 1956). «Remarks on Some Nonparametric Estimates of a Density Function». The Annals of Mathematical Statistics (em inglês). 27 (3): 832-837. ISSN 0003-4851. doi:10.1214/aoms/1177728190

- ↑ a b Parzen, Emanuel (1 de setembro de 1962). «On Estimation of a Probability Density Function and Mode». The Annals of Mathematical Statistics (em inglês). 33 (3): 1065-1076. ISSN 0003-4851. doi:10.1214/aoms/1177704472

- ↑ Epanechnikov, V.A. (1969). «Non-parametric estimation of a multivariate probability density». Theory of Probability and its Applications. 14: 153–158. doi:10.1137/1114019

- ↑ Wand, M.P; Jones, M.C. (1995). Kernel Smoothing. London: Chapman & Hall/CRC. ISBN 0-412-55270-1

- ↑ Scott, D. (1979). «On optimal and data-based histograms». Biometrika. 66 (3): 605–610. doi:10.1093/biomet/66.3.605

- ↑ Park, B.U.; Marron, J.S. (1990). «Comparison of data-driven bandwidth selectors». Journal of the American Statistical Association. 85 (409): 66–72. JSTOR 2289526. doi:10.1080/01621459.1990.10475307

- ↑ Park, B.U.; Turlach, B.A. (1992). «Practical performance of several data driven bandwidth selectors (with discussion)». Computational Statistics. 7: 251–270

- ↑ Cao, R.; Cuevas, A.; Manteiga, W. G. (1994). «A comparative study of several smoothing methods in density estimation». Computational Statistics and Data Analysis. 17 (2): 153–176. doi:10.1016/0167-9473(92)00066-Z

- ↑ Jones, M.C.; Marron, J.S.; Sheather, S. J. (1996). «A brief survey of bandwidth selection for density estimation». Journal of the American Statistical Association. 91 (433): 401–407. JSTOR 2291420. doi:10.2307/2291420

- ↑ Sheather, S.J. (1992). «The performance of six popular bandwidth selection methods on some real data sets (with discussion)». Computational Statistics. 7: 225–250, 271–281

- ↑ a b Sheather, S.J.; Jones, M.C. (1991). «A reliable data-based bandwidth selection method for kernel density estimation». Journal of the Royal Statistical Society, Series B. 53 (3): 683–690. JSTOR 2345597

- ↑ Rudemo, M. (1982). «Empirical choice of histograms and kernel density estimators». Scandinavian Journal of Statistics. 9 (2): 65–78. JSTOR 4615859

- ↑ Bowman, A.W. (1984). «An alternative method of cross-validation for the smoothing of density estimates». Biometrika. 71 (2): 353–360. doi:10.1093/biomet/71.2.353

- ↑ Hall, P.; Marron, J.S.; Park, B.U. (1992). «Smoothed cross-validation». Probability Theory and Related Fields. 92: 1–20. doi:10.1007/BF01205233

- ↑ Wahba, G. (1975). «Optimal convergence properties of variable knot, kernel, and orthogonal series methods for density estimation». Annals of Statistics. 3 (1): 15–29. doi:10.1214/aos/1176342997

- ↑ Silverman, B.W. (1998). Density Estimation for Statistics and Data Analysis. London: Chapman & Hall/CRC. p. 48. ISBN 0-412-24620-1