Autovalores e autovetores

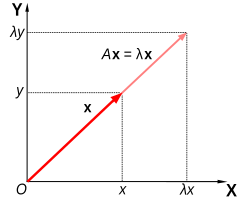

Em álgebra linear, um escalar λ diz-se um valor próprio,[1] autovalor[1][2][3] ou valor característico[1][2][4] de um operador linear se existir um vetor x diferente de zero tal que . O vetor x é chamado vetor próprio, autovetor ou vetor característico.

Os autovalores de uma dada matriz quadrada A de dimensão são os n números que resumem as propriedades essenciais daquela matriz. O autovalor de A é um número λ tal que, se for subtraído de cada entrada na diagonal de A, converte A numa matriz singular (ou não-invertível). Subtrair um escalar λ de cada entrada na diagonal de A é o mesmo que subtrair λ vezes a matriz identidade I de A. Portanto, λ é um autovalor se, e somente se, a matriz for singular.[5]

História

[editar | editar código-fonte]

Os autovalores são frequentemente introduzidos no contexto da álgebra linear ou da teoria das matrizes. Historicamente, no entanto, eles surgiram no estudo de formas quadráticas e equações diferenciais.

No século XVIII, Leonhard Euler estudou o movimento rotacional de um corpo rígido, e descobriu a importância dos eixos principais.[a] Joseph-Louis Lagrange percebeu que os eixos principais são os autovetores da matriz de inércia.[6]

No início do século XIX, Augustin-Louis Cauchy viu como seu trabalho poderia ser usado para classificar as superfícies quádricas, e generalizou-o para dimensões arbitrárias.[7] Cauchy também cunhou o termo racine caractéristique (raiz característica), para o que agora é chamado de autovalor; seu termo sobrevive na equação característica.[b]

Mais tarde, Joseph Fourier usou o trabalho de Lagrange e Pierre-Simon Laplace para resolver a equação do calor por separação de variáveis em seu famoso livro de 1822, Théorie analytique de la chaleur.[8] Charles-François Sturm desenvolveu ainda mais as ideias de Fourier e chamou a atenção de Cauchy, que as combinou com suas próprias ideias e chegou ao fato de que matrizes simétricas reais têm autovalores reais.[7] Isso foi estendido por Charles Hermite em 1855 para o que hoje é chamado de matrizes hermitianas.[9]

Na mesma época, Francesco Brioschi provou que os autovalores de matrizes ortogonais estão no círculo unitário,[7] e Alfred Clebsch encontrou o resultado correspondente para matrizes assimétricas.[9] Finalmente, Karl Weierstrass esclareceu um aspecto importante na teoria da estabilidade iniciada por Laplace, ao perceber que matrizes defeituosas podem causar instabilidade.[7]

Nesse ínterim, Joseph Liouville estudou problemas de autovalor semelhantes aos de Sturm; a disciplina que surgiu de seu trabalho agora é chamada de teoria de Sturm-Liouville.[10] Schwarz estudou o primeiro autovalor da equação de Laplace em domínios gerais no final do século XIX, enquanto Poincaré estudou a equação de Poisson alguns anos depois.[11]

No início do século 20, David Hilbert estudou os autovalores dos operadores integrais, visualizando os operadores como matrizes infinitas.[12] Ele foi o primeiro a usar a palavra alemã eigen, que significa "próprio",[13] para denotar autovalores e autovetores em 1904,[c] embora possa ter seguido um uso relacionado por Hermann von Helmholtz. Por algum tempo, o termo padrão em inglês era "valor adequado", mas o termo mais distinto "valor próprio" é o padrão hoje.[14]

O primeiro algoritmo numérico para calcular autovalores e autovetores apareceu em 1929, quando Richard von Mises publicou o método da potência. Um dos métodos mais populares hoje, o algoritmo QR, foi proposto independentemente por John G. F. Francis[15] e Vera Kublanovskaya[16] em 1961.[17][18]

Definição formal

[editar | editar código-fonte]Se T é uma transformação linear de um espaço vetorial V sobre um corpo F em si mesmo e v é um vetor diferente de zero em V, então v é um autovetor de T se T(v) é um múltiplo escalar de v. Isso pode ser escrito como

onde λ é um escalar em F, conhecido como autovalor, valor característico, ou raiz característica associada a v.

Existe uma correspondência direta entre matrizes quadradas n-por-n e transformações lineares de um espaço vetorial n-dimensional para si mesmo, dada qualquer base do espaço vetorial. Portanto, em um espaço vetorial de dimensão finita, é equivalente a definir autovalores e autovetores usando a linguagem de matrizes, ou a linguagem de transformações lineares.[19][20]

Se V é de dimensão finita, a equação acima é equivalente a[21]onde A é a representação matricial de T e u é o vetor de coordenadas de v.

Autovalores e autovetores de matrizes

[editar | editar código-fonte]Autovalores e autovetores são frequentemente apresentados aos alunos no contexto de cursos de álgebra linear focados em matrizes.[22][23] Além disso, transformações lineares em um espaço vetorial de dimensão finita podem ser representadas usando matrizes,[24][20] o que é especialmente comum em aplicações numéricas e computacionais.[25]

Considere vetores n-dimensionais que são formados como uma lista de n escalares, como os vetores tridimensionais.

Esses vetores são ditos múltiplos escalares um do outro, ou paralelos ou colineares, se existe um escalar λ tal que

Nesse caso .

Agora considere a transformação linear de vetores n-dimensionais definidos por uma matriz A n-por-n,

ou

onde, para cada linha,

Se ocorrer que v e w são múltiplos escalares, isto é, se

-

(1)

então v é um autovetor da transformação linear A e o fator de escala λ é o autovalor correspondente a esse autovetor. A equação (1) é a equação de autovalor para a matriz A.

A equação (1) pode ser expressa de forma equivalente como

-

(2)

onde I é a matriz identidade n-por-n e 0 é o vetor zero.

Autovalores e o polinômio característico

[editar | editar código-fonte]A equação (2) tem solução v diferente de zero se e somente se o determinante da matriz (A − λI) for zero. Portanto, os autovalores de A são valores de λ que satisfazem a equação

-

(3)

Usando a fórmula de Leibniz para determinantes, o lado esquerdo da Equação (3) é uma função polinomial da variável λ e o grau deste polinômio é n, a ordem da matriz A. Seus coeficientes dependem das entradas de A, exceto que seu termo de grau n é sempre (−1)nλn. Este polinômio é chamado de polinômio característico de A. A equação (3) é chamada de equação característica ou equação secular de A.

O teorema fundamental da álgebra implica que o polinômio característico de uma matriz A n-por-n, sendo um polinômio de grau n, pode ser fatorado no produto de n termos lineares,

-

(4)

onde cada λi pode ser real, mas em geral é um número complexo. Os números λ1, λ2, ..., λn, que podem não ter valores distintos, são raízes do polinômio e são os autovalores de A. Uma matriz quadrada A é singular se, e somente se, 0 é um autovalor de A.

Como um breve exemplo, que é descrito em mais detalhes na seção de exemplos mais adiante, considere a matrizTomando o determinante de (A − λI), o polinômio característico de A é

Definindo o polinômio característico igual a zero, ele tem raízes em λ=1 e λ=3, que são os dois autovalores de A. Os autovetores correspondentes a cada autovalor podem ser encontrados resolvendo os componentes de v na equação . Neste exemplo, os autovetores são quaisquer múltiplos escalares diferentes de zero de

Se as entradas da matriz A forem todas números reais, então os coeficientes do polinômio característico também serão números reais, mas os autovalores ainda podem ter partes imaginárias diferentes de zero. As entradas dos autovetores correspondentes, portanto, também podem ter partes imaginárias diferentes de zero. Da mesma forma, os autovalores podem ser números irracionais, mesmo que todas as entradas de A sejam números racionais ou mesmo que sejam todos inteiros. No entanto, se as entradas de A são todos números algébricos, que incluem os racionais, os autovalores são números algébricos complexos.

As raízes não reais de um polinômio real com coeficientes reais podem ser agrupadas em pares de conjugados complexos, ou seja, com os dois membros de cada par tendo partes imaginárias que diferem apenas em sinal e a mesma parte real. Se o grau for ímpar, pelo teorema do valor intermediário, pelo menos uma das raízes é real. Portanto, qualquer matriz real de ordem ímpar tem pelo menos um autovalor real, enquanto uma matriz real de ordem par pode não ter nenhum autovalor real. Os autovetores associados a esses autovalores complexos também são complexos e também aparecem em pares conjugados complexos.

Interpretação geométrica

[editar | editar código-fonte]

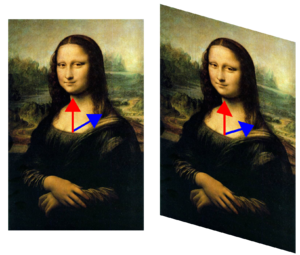

Geometricamente, a equação do valor próprio (autovalor) implica que numa transformação A, autovetores sofrem apenas mudança na sua magnitude e sinal — a direção de Ax é a mesma direção de x. O autovalor λ indica apenas o quanto o vetor irá "encolher" ou "esticar" ao sofrer a transformação A. Se λ = 1, o vetor permanece inalterado (não é afetado pela transformação). Se λ = −1 o vetor passa a ter apenas o sentido oposto e a transformação é chamada reflexão. A transformação I sob a qual um vetor x permanece inalterado, Ix = x é definida como transformação identidade.

Multiplicidade algébrica

[editar | editar código-fonte]Seja λi um autovalor de uma matriz A n-por-n. A multiplicidade algébrica μA(λi) do autovalor é sua multiplicidade como raiz do polinômio característico, ou seja, o maior inteiro k tal que (λ − λi)k divide igualmente esse polinômio.[26][27][28]

Suponha que uma matriz A tenha dimensão n e d ≤ n autovalores distintos. Considerando que a Equação (4) fatora o polinômio característico de A no produto de n termos lineares com alguns termos potencialmente repetidos, o polinômio característico pode, em vez disso, ser escrito como o produto de d termos, cada um correspondendo a um autovalor distinto e elevado à potência do multiplicidade algébrica,

Se d = n então o lado direito é o produto de n termos lineares e isso é o mesmo que a Equação (4). O tamanho da multiplicidade algébrica de cada autovalor está relacionado com a dimensão n como

Se μA(λi) = 1, então λi é um autovalor simples.[28] Se μA(λi) é igual à multiplicidade geométrica de λi, γA(λi), definida na próxima seção, então λi é dito ser um autovalor semisimples.

Autoespaços, multiplicidade geométrica e autobase para matrizes

[editar | editar código-fonte]Dado um autovalor particular λ da matriz A n por n, defina o conjunto E como sendo todos os vetores v que satisfazem a Equação (2),

Por um lado, esse conjunto é justamente o núcleo ou espaço nulo da matriz (A − λI). Por outro lado, por definição, qualquer vetor diferente de zero que satisfaça esta condição é um autovetor de A associado a λ. Assim, o conjunto E é a união do vetor nulo com o conjunto de todos os autovetores de A associados a λ, e E é igual ao espaço nulo de (A − λI). E é chamado de autoespaço ou espaço característico de A associado a λ.[29][26] Em geral λ é um número complexo e os autovetores são matrizes n por 1 complexas. Uma propriedade do espaço nulo é que ele é um subespaço linear, então E é um subespaço linear de .

Como o autoespaço E é um subespaço linear, ele é fechado sob adição. Ou seja, se dois vetores u e v pertencem ao conjunto E, escrito u, v ∈ E, então (u + v) ∈ E ou equivalentemente A(u + v) = λ(u + v). Isso pode ser verificado usando a propriedade distributiva da multiplicação de matrizes. Da mesma forma, como E é um subespaço linear, ele é fechado sob multiplicação escalar. Ou seja, se v ∈ E e α é um número complexo, (αv) ∈ E ou equivalentemente A(αv) = λ(αv). Isso pode ser verificado observando que a multiplicação de matrizes complexas por números complexos é comutativa. Desde que u + v e αv não sejam zero, eles também são autovetores de A associados a λ.

A dimensão do autoespaço E associado a λ, ou equivalentemente o número máximo de autovetores linearmente independentes associados a λ, é referido como a multiplicidade geométrica do autovalor γA(λ). Como E também é o espaço nulo de (A − λI), a multiplicidade geométrica de λ é a dimensão do espaço nulo de (A − λI), também chamada de nulidade de (A − λI), que se relaciona com a dimensão e o posto de (A − λI) como

Devido à definição de autovalores e autovetores, a multiplicidade geométrica de um autovalor deve ser pelo menos um, ou seja, cada autovalor tem pelo menos um autovetor associado. Além disso, a multiplicidade geométrica de um autovalor não pode exceder sua multiplicidade algébrica. Além disso, lembre-se de que a multiplicidade algébrica de um autovalor não pode exceder n.

Para provar a desigualdade , considere como a definição de multiplicidade geométrica implica a existência de autovetores ortonormais , de tal modo que . Podemos, portanto, encontrar uma matriz (unitária) cujo primeiro colunas são esses autovetores e cujas colunas restantes podem ser qualquer conjunto ortonormal de vetores ortogonais a esses autovetores de . Então tem posto completo e, portanto, é invertível, e com uma matriz cujo bloco superior esquerdo é a matriz diagonal . Isso implica que . Em outras palavras, é similar a , o que implica que . Mas a partir da definição de nós sabemos isso contém um fator , o que significa que a multiplicidade algébrica de deve satisfazer .

Suponha tem autovalores distintos , onde a multiplicidade geométrica de é . A multiplicidade geométrica total de ,

é a dimensão da soma de todos os autoespaços de autovalores de , ou equivalentemente o número máximo de autovetores linearmente independentes de . Se , então

- A soma direta dos autoespaços de todos os autovalores de é todo o espaço vetorial .

- Uma base de pode ser formado a partir de autovetores linearmente independentes de ; tal base é chamada de autobase.

- Qualquer vetor em pode ser escrita como uma combinação linear de autovetores de .

Propriedades adicionais de autovalores

[editar | editar código-fonte]Deixar ser um arbitrário matriz de números complexos com autovalores . Cada autovalor aparece vezes nesta lista, onde é a multiplicidade algébrica do autovalor. A seguir estão as propriedades desta matriz e seus autovalores:

- O traço de , definido como a soma de seus elementos diagonais, é também a soma de todos os autovalores,[30][31][32]

- O determinante de é o produto de todos os seus autovalores,[30][33][34]

- Os autovalores do o poder de ; ou seja, os autovalores de , para qualquer inteiro positivo , está .

- A matriz é invertível se e somente se todo autovalor for diferente de zero.

- Se é invertível, então os autovalores de são e a multiplicidade geométrica de cada autovalor coincide. Além disso, como o polinômio característico da inversa é o polinômio recíproco do original, os autovalores compartilham a mesma multiplicidade algébrica.

- Se é igual a sua transposta conjugada , ou equivalente se é hermitiana, então todo autovalor é real. O mesmo vale para qualquer matriz real simétrica.

- Se não é apenas hermitiana, mas também positiva definida, semidefinida positiva, definida negativa ou semidefinida negativa, então todo autovalor é positivo, não negativo, negativo ou não positivo, respectivamente.

- Se é unitário, todo autovalor tem valor absoluto .

- E se é um matriz e são seus autovalores, então os autovalores da matriz (Onde é a matriz identidade) são . Além disso, se , os autovalores de são . Mais geralmente, para um polinômio os autovalores da matriz são .

Autovetores esquerdo e direito

[editar | editar código-fonte]Muitas disciplinas tradicionalmente representam vetores como matrizes com uma única coluna em vez de matrizes com uma única linha. Por essa razão, a palavra "autovetor" no contexto de matrizes quase sempre se refere a um autovetor à direita, ou seja, um vetor coluna que multiplica à direita o matriz na equação definidora, Equação (1),

O problema de autovalor e autovetor também pode ser definido para vetores de linha que deixaram a matriz de multiplicação . Nesta formulação, a equação definidora é

Onde é um escalar e é uma matriz . Qualquer vetor linha satisfazendo esta equação é chamado de autovetor esquerdo de e é o seu autovalor associado. Fazendo a transposta dessa equação,

Comparando esta equação com a Equação (1), segue-se imediatamente que um autovetor esquerdo de é o mesmo que a transposição de um autovetor à direita de , com o mesmo autovalor. Além disso, como o polinômio característico de é o mesmo que o polinômio característico de , os autovalores dos autovetores esquerdos de são os mesmos que os autovalores dos autovetores corretos de .

Diagonalização e autodecomposição

[editar | editar código-fonte]Suponha que os autovetores de A formem uma base, ou equivalentemente A tem n autovetores linearmente independentes v1, v2, ..., vn com autovalores associados λ1, λ2, ..., λn. Os autovalores não precisam ser distintos. Defina uma matriz quadrada Q cujas colunas são os n autovetores linearmente independentes de A,

Como cada coluna de Q é um autovetor de A, a multiplicação à direita de A por Q escala cada coluna de Q por seu autovalor associado,

Com isso em mente, defina uma matriz diagonal Λ onde cada elemento diagonal Λii é o autovalor associado à i-ésima coluna de Q. Então

Como as colunas de Q são linearmente independentes, Q é invertível. Multiplicando à direita ambos os lados da equação por Q−1,

ou, em vez disso, multiplicando ambos os lados por Q−1,

A pode, portanto, ser decomposto em uma matriz composta por seus autovetores, uma matriz diagonal com seus autovalores ao longo da diagonal e o inverso da matriz de autovetores. Isso é chamado de autodecomposição e é uma transformação de similaridade. Tal matriz A é dita similar à matriz diagonal Λ ou diagonalizável. A matriz Q é a matriz de mudança de base da transformação de similaridade. Essencialmente, as matrizes A e Λ representam a mesma transformação linear expressa em duas bases diferentes. Os autovetores são usados como base ao representar a transformação linear como Λ.

Reciprocamente, suponha que uma matriz A seja diagonalizável. Seja P uma matriz quadrada não singular tal que P−1AP seja alguma matriz diagonal D. Esquerda multiplicando ambos por P, AP = PD. Cada coluna de P deve, portanto, ser um autovetor de A cujo autovalor é o elemento diagonal correspondente de D. Como as colunas de P devem ser linearmente independentes para que P seja invertível, existem n autovetores linearmente independentes de A. Segue-se então que o autovetores de A formam uma base se e somente se A é diagonalizável.

Uma matriz que não é diagonalizável é dita defeituosa. Para matrizes defeituosas, a noção de autovetores generaliza para autovetores generalizados e a matriz diagonal de autovalores generaliza para a forma normal de Jordan. Sobre um corpo algebricamente fechado, qualquer matriz A tem uma forma normal de Jordan e, portanto, admite uma base de autovetores generalizados e uma decomposição em autoespaços generalizados.

Exemplos de matrizes

[editar | editar código-fonte]Exemplo de matriz bidimensional

[editar | editar código-fonte]

Considere a matriz

A figura à direita mostra o efeito desta transformação nas coordenadas do ponto no plano. Os autovetores v desta transformação satisfazem a Equação (1), e os valores de λ para os quais o determinante da matriz (A − λI) é igual a zero são os autovalores.

Tomando o determinante para encontrar o polinômio característico de A,

Igualando o polinômio característico a zero, ele tem raízes em λ=1 e λ=3, que são os dois autovalores de A.

Para λ=1, a Equação (2) torna-se,

Qualquer vetor diferente de zero com v1 = −v2 resolve esta equação. Portanto, é um autovetor de A correspondente a λ = 1, assim como qualquer múltiplo escalar desse vetor.

Para λ=3, a Equação (2) torna-se

Qualquer vetor diferente de zero com v1 = v2 resolve esta equação. Portanto,

é um autovetor de A correspondente a λ = 3, assim como qualquer múltiplo escalar desse vetor.

Assim, os vetores vλ=1 e vλ=3 são autovetores de A associados aos autovalores λ=1 e λ=3, respectivamente.

Às vezes é possível descobrir um ou mais autovalores de uma matriz por inspeção.[5] Seja, por exemplo, a matriz .[35] Subtraindo 2 de cada entrada da diagonal principal, transformamos A em uma matriz singular: . Portanto, 2 é um autovalor da matriz A. Também subtraindo 4 de cada entrada da diagonal principal, transformamos A em uma matriz singular: . Portanto, 4 é o segundo autovalor da matriz A.

Exemplo de matriz tridimensional

[editar | editar código-fonte]Considere a matriz

O polinômio característico de A é

As raízes do polinômio característico são 2, 1 e 11, que são os únicos três autovalores de A. Esses autovalores correspondem aos autovetores , , e , ou qualquer múltiplo diferente de zero.

Exemplo de matriz tridimensional com autovalores complexos

[editar | editar código-fonte]Considere a matriz de permutação cíclica

Esta matriz desloca as coordenadas do vetor para cima em uma posição e move a primeira coordenada para baixo. Seu polinômio característico é 1 −λ3, cujas raízes são

onde é uma unidade imaginária com .

Para o autovalor real λ1 = 1, qualquer vetor com três entradas iguais diferentes de zero é um autovetor. Por exemplo,

Para o par complexo conjugado de autovalores imaginários,

Então

e

Portanto, os outros dois autovetores de A são complexos e são e com autovalores λ2 e λ3, respectivamente. Os dois autovetores complexos também aparecem em um par conjugado complexo,

Exemplo de matriz diagonal

[editar | editar código-fonte]Matrizes com entradas apenas ao longo da diagonal principal são chamadas de matrizes diagonais. Os autovalores de uma matriz diagonal são os próprios elementos diagonais. Considere a matriz

O polinômio característico de A é

que tem as raízes λ1 = 1, λ2 = 2 e λ3 = 3. Essas raízes são os elementos diagonais, bem como os autovalores de A.

Cada elemento da diagonal corresponde a um autovetor cujo único componente diferente de zero está na mesma linha daquele elemento da diagonal. No exemplo, os autovalores correspondem aos autovetores,

respectivamente, bem como múltiplos escalares desses vetores.

Exemplo de matriz triangular

[editar | editar código-fonte]Uma matriz cujos elementos acima da diagonal principal são todos nulos é chamada de matriz triangular inferior, enquanto uma matriz cujos elementos abaixo da diagonal principal são todos nulos é chamada de matriz triangular superior. Assim como nas matrizes diagonais, os autovalores das matrizes triangulares são os elementos da diagonal principal.

Considere a matriz triangular inferior,

O polinômio característico de A é

que tem as raízes λ1 = 1, λ2 = 2 e λ3 = 3. Essas raízes são os elementos diagonais, bem como os autovalores de A.

Esses autovalores correspondem aos autovetores,

respectivamente, bem como múltiplos escalares desses vetores.

Exemplo de matriz com autovalores repetidos

[editar | editar código-fonte]Como no exemplo anterior, a matriz triangular inferior

tem um polinômio característico que é o produto de seus elementos diagonais,

As raízes deste polinômio e, portanto, os autovalores, são 2 e 3. A multiplicidade algébrica de cada autovalor é 2; em outras palavras, ambas são raízes duplas. A soma das multiplicidades algébricas de todos os autovalores distintos é μA = 4 = n, a ordem do polinômio característico e a dimensão de A.

Por outro lado, a multiplicidade geométrica do autovalor 2 é apenas 1, porque seu autoespaço é gerado por apenas um vetor e é, portanto, unidimensional. Da mesma forma, a multiplicidade geométrica do autovalor 3 é 1 porque seu autoespaço é gerado por apenas um vetor . A multiplicidade geométrica total γA é 2, que é a menor que poderia ser para uma matriz com dois autovalores distintos. Multiplicidades geométricas são definidas em uma seção posterior.

Identidade autovetor-autovalor

[editar | editar código-fonte]Para uma matriz hermitiana, a norma ao quadrado do componente j-ésima de um autovetor normalizado pode ser calculada usando apenas os autovalores da matriz e os autovalores da matriz menor correspondente, Onde é a submatriz formada pela remoção da j-ésima linha e coluna da matriz original.[36][37][38] Essa identidade também se estende a matrizes diagonalizáveis e foi redescoberta muitas vezes na literatura.[37]

Notas

- ↑ Note:

- In 1751, Leonhard Euler proved that any body has a principal axis of rotation: Leonhard Euler (presented: October 1751; published: 1760) "Du mouvement d'un corps solide quelconque lorsqu'il tourne autour d'un axe mobile" (On the movement of any solid body while it rotates around a moving axis), Histoire de l'Académie royale des sciences et des belles lettres de Berlin, pp. 176–227. On p. 212, Euler proves that any body contains a principal axis of rotation: "Théorem. 44. De quelque figure que soit le corps, on y peut toujours assigner un tel axe, qui passe par son centre de gravité, autour duquel le corps peut tourner librement & d'un mouvement uniforme." (Theorem. 44. Whatever be the shape of the body, one can always assign to it such an axis, which passes through its center of gravity, around which it can rotate freely and with a uniform motion.)

- In 1755, Johann Andreas Segner proved that any body has three principal axes of rotation: Johann Andreas Segner, Specimen theoriae turbinum [Essay on the theory of tops (i.e., rotating bodies)] ( Halle ("Halae"), (Germany): Gebauer, 1755). (https://books.google.com/books?id=29 p. xxviiii [29]), Segner derives a third-degree equation in t, which proves that a body has three principal axes of rotation. He then states (on the same page): "Non autem repugnat tres esse eiusmodi positiones plani HM, quia in aequatione cubica radices tres esse possunt, et tres tangentis t valores." (However, it is not inconsistent [that there] be three such positions of the plane HM, because in cubic equations, [there] can be three roots, and three values of the tangent t.)

- The relevant passage of Segner's work was discussed briefly by Arthur Cayley. See: A. Cayley (1862) "Report on the progress of the solution of certain special problems of dynamics," Report of the Thirty-second meeting of the British Association for the Advancement of Science; held at Cambridge in October 1862, 32: 184–252; see especially pp. 225–226.

- ↑ Kline 1972, pp. 807–808 Augustin Cauchy (1839) "Mémoire sur l'intégration des équations linéaires" (Memoir on the integration of linear equations), Comptes rendus, 8: 827–830, 845–865, 889–907, 931–937. From p. 827: "On sait d'ailleurs qu'en suivant la méthode de Lagrange, on obtient pour valeur générale de la variable prinicipale une fonction dans laquelle entrent avec la variable principale les racines d'une certaine équation que j'appellerai l'équation caractéristique, le degré de cette équation étant précisément l'order de l'équation différentielle qu'il s'agit d'intégrer." (One knows, moreover, that by following Lagrange's method, one obtains for the general value of the principal variable a function in which there appear, together with the principal variable, the roots of a certain equation that I will call the "characteristic equation", the degree of this equation being precisely the order of the differential equation that must be integrated.)

- ↑ See:

- David Hilbert (1904) "Grundzüge einer allgemeinen Theorie der linearen Integralgleichungen. (Erste Mitteilung)" (Fundamentals of a general theory of linear integral equations. (First report)), Nachrichten von der Gesellschaft der Wissenschaften zu Göttingen, Mathematisch-Physikalische Klasse (News of the Philosophical Society at Göttingen, mathematical-physical section), pp. 49–91. From p. 51: "Insbesondere in dieser ersten Mitteilung gelange ich zu Formeln, die die Entwickelung einer willkürlichen Funktion nach gewissen ausgezeichneten Funktionen, die ich 'Eigenfunktionen' nenne, liefern: ..." (In particular, in this first report I arrive at formulas that provide the [series] development of an arbitrary function in terms of some distinctive functions, which I call eigenfunctions: ... ) Later on the same page: "Dieser Erfolg ist wesentlich durch den Umstand bedingt, daß ich nicht, wie es bisher geschah, in erster Linie auf den Beweis für die Existenz der Eigenwerte ausgehe, ... " (This success is mainly attributable to the fact that I do not, as it has happened until now, first of all aim at a proof of the existence of eigenvalues, ... )

- For the origin and evolution of the terms eigenvalue, characteristic value, etc., see: Earliest Known Uses of Some of the Words of Mathematics (E)

Ver também

[editar | editar código-fonte]- Vetor próprio

- Decomposição em Valores Singulares - valor singular e vetor singular (ideias semelhantes para matrizes retangulares)

- Forma canônica de Jordan

- wikibooks:Linear Algebra/Eigenvalues and eigenvectors

Referências

- ↑ a b c Callioli, Domingues & Costa, p. 258

- ↑ a b Leon, p. 212

- ↑ Abramo & Fernandez, p. 204

- ↑ Hoffman & Kunze, p. 177

- ↑ a b SIMON, Carl P., e BLUME, Lawrence. matemática para Economistas.Porto Alegre: Bookman, 2004, reimpressão 2008. ISBN 978-85-363-0307-9. Capítulo 23, página 583 a 585.

- ↑ Hawkins 1975, §2.

- ↑ a b c d Hawkins 1975, §3.

- ↑ Kline 1972, p. 673.

- ↑ a b Kline 1972, pp. 807–808.

- ↑ Kline 1972, pp. 715–716.

- ↑ Kline 1972, pp. 706–707.

- ↑ Kline 1972, p. 1063, p..

- ↑ www.mathsisfun.com.Retrieved 19 August 2020."Eigenvector and Eigenvalue"

- ↑ Aldrich 2006.

- ↑ Francis 1961, pp. 265–271.

- ↑ Kublanovskaya 1962.

- ↑ Golub & Van Loan 1996, §7.3.

- ↑ Meyer 2000, §7.3.

- ↑ Herstein 1964, pp. 228, 229.

- ↑ a b Nering 1970, p. 38.

- ↑ Weisstein n.d.

- ↑ Cornell University Department of Mathematics (2016) Lower-Level Courses for Freshmen and Sophomores. Accessed on 2016-03-27.

- ↑ University of Michigan Mathematics (2016) Math Course Catalogue Arquivado em 2015-11-01 no Wayback Machine. Accessed on 2016-03-27.

- ↑ Herstein 1964, pp. 228,229.

- ↑ Press et al. 2007, p. 38.

- ↑ a b Nering 1970, p. 107.

- ↑ Fraleigh 1976, p. 358.

- ↑ a b Golub & Van Loan 1996, p. 316.

- ↑ Anton 1987, pp. 305,307.

- ↑ a b Beauregard & Fraleigh 1973, p. 307.

- ↑ Herstein 1964, p. 272.

- ↑ Nering 1970, pp. 115–116.

- ↑ Herstein 1964, p. 290.

- ↑ Nering 1970, p. 116.

- ↑ «O Monitor - Resolve, confere e ilustra». omonitor.io. Consultado em 19 de março de 2016

- ↑ Wolchover 2019.

- ↑ a b Denton et al. 2022.

- ↑ Van Mieghem 2014.

Bibliografia

[editar | editar código-fonte]- Leon, Steven J. (1998). Álgebra Linear Com Aplicações 4 ed. Rio de Janeiro: LTC. 390 páginas. ISBN 8521611501

- Hefez, Abramo; Fernandez, Cecília S. (2016). Introdução à Álgebra Linear 2 ed. Rio de Janeiro: SBM. 271 páginas. ISBN 9788583370871

- Hoffman, Kenneth; Kunze, Ray (1976). Álgebra Linear 1 ed. Rio de Janeiro: LTC. 356 páginas

- Callioli, Carlos A.; Domingues, Hygino H.; Costa, Roberto C. F. (1983). Álgebra Linear e Aplicações 4 ed. São Paulo: Atual. 332 páginas

![{\displaystyle \left[{\begin{smallmatrix}2&1\\1&2\end{smallmatrix}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/838a30dc9d065ec434dff490bd84061ed569db3b)

![{\displaystyle {\begin{aligned}|A-\lambda I|&=\left|{\begin{bmatrix}2&1\\1&2\end{bmatrix}}-\lambda {\begin{bmatrix}1&0\\0&1\end{bmatrix}}\right|={\begin{vmatrix}2-\lambda &1\\1&2-\lambda \end{vmatrix}}\\[6pt]&=3-4\lambda +\lambda ^{2}\\[6pt]&=(\lambda -3)(\lambda -1).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0084c80ab8c7637830cdf01f1c754f92a6598ac0)

![{\displaystyle {\begin{aligned}|A-\lambda I|&=\left|{\begin{bmatrix}2&0&0\\0&3&4\\0&4&9\end{bmatrix}}-\lambda {\begin{bmatrix}1&0&0\\0&1&0\\0&0&1\end{bmatrix}}\right|={\begin{vmatrix}2-\lambda &0&0\\0&3-\lambda &4\\0&4&9-\lambda \end{vmatrix}},\\[6pt]&=(2-\lambda ){\bigl [}(3-\lambda )(9-\lambda )-16{\bigr ]}=-\lambda ^{3}+14\lambda ^{2}-35\lambda +22.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/30165fb86a7e23644d2e3373a1c2c68af4756523)