Neurônio artificial

Este artigo ou se(c)ção carece de reciclagem de acordo com o livro de estilo. |

Um neurônio artificial representa a base de uma rede neural artificial, um modelo da neurocomputação (às vezes também: neuroinformática) e orientado nas redes neurais biológicas.

Histórico

[editar | editar código-fonte]

A maior parte dos computadores disponíveis hoje segue o modelo de arquitetura de Von Neumann. Estes computadores apresentam um bom desempenho para tarefas comuns como processamento de números, transações, etc. No entanto, existe uma grande gama de aplicações que não são facilmente modeladas para os computadores convencionais. Estas aplicações geralmente são aquelas facilmente resolvidas por seres humanos como, por exemplo, reconhecimento de faces, classificação de dados, filtragem de informações, etc. Neste contexto, as redes neurais artificiais surgem como uma alternativa as arquiteturas tradicionais. A ideia básica das redes neurais é imitar o funcionamento do cérebro humano e construir sistemas computacionais capazes de aprender, fazer generalizações e descobertas.

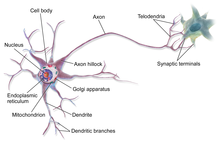

A origem da teoria de Redes Neurais remota aos modelos matemáticos e aos modelos de engenharia de neurônios biológicos. A célula nervosa, ou neurônio, foi identificado anatomicamente e descrito com notável detalhe, pelo neurologista espanhol Ramon y Cajal no século 19. Como qualquer célula biológica, o neurônio é delimitado por uma fina membrana celular que além de sua função biológica normal, possui determinadas propriedades que são essenciais para o funcionamento elétrico da célula nervosa. A partir do centro celular, ou soma,- o centro de processos metabólicos da célula nervosa -projetam-se extensões filamentares, os dendritos, e o axônio.[1]

Frequentemente, os dendritos cobrem um volume muitas vezes maior do que o próprio corpo celular e formam uma árvore detrital . A outra projeção filamentar do corpo celular, o axônio, também referido à fibra nervosa, serve para conectar a célula nervosa a outras partes do sistema nervoso. O neurônio possui geralmente um único axônio, embora esse possa apresentar algumas ramificações. Em alguns casos, estende-se por distâncias comparáveis às dimensões de organismos podendo chegar a vários metros. Alguns tipos de neurônios, a grande maioria dos que constituem o sistema nervoso central dos vertebrados, possui uma capa segmentada de mielina, que serve para acelerar a transmissão de informação pelo axônio.

As manifestações elétricas de neurônios biológicos foram observadas pela primeira vez no século 19 por Dubois Reymond com o auxílio de galvanômetros. O funcionamento dessas células começou a ser melhor entendido com a invenção no final do século 19 de Crookes, do tubo de raios catódicos e com a sua aplicação à observação da atividade elétrica nervosa, principalmente por Erlanger e Gasser, na década de 1920. Essas investigações lhe renderam o prêmio Nobel de fisiologia em 1944. Nas duas décadas seguintes, como resultado do trabalho de vários pesquisadores, passou a entender o neurônio biológico como sendo um dispositivo computacional elementar do sistema nervoso, que possuía muitas entradas sinápticas, e uma saída. As entradas ocorrem através de conexões sinápticas, que conectam a árvore dendrítica aos axônios de outras células nervosas. Os sinais que chegam por esses axônios são pulsos elétricos conhecidos como impulsos nervosos ou potenciais de ação, e constituem a informação que o neurônio processará, de alguma forma, para produzir como saída um impulso nervoso no seu axônio.[2][1]

Em 1943, McCulloch e Pitts[3] apresentaram o primeiro modelo matemático do neurônio. Esse modelo, conhecido como MCP (McCulloch-Pitts), é uma simplificação do neurônio biológico, que considera o neurônio como uma unidade de processamento de informações binárias, com várias entradas binárias e uma única saída binária. O modelo MCP foi um marco importante no desenvolvimento das Redes Neurais, pois mostrou que um sistema de neurônios interconectados, com apropriadas regras de conexão, poderia ser usado para realizar tarefas de processamento de informações.

Em 1948, Wiener publicou o livro Cybernetics[4], que apresentava as ideias fundamentais da teoria cibernética, que se tornaria uma importante base teórica para o desenvolvimento das Redes Neurais. No mesmo ano, Von Neumann divulgou a teoria de McCulloch e Pitts em uma palestra na Universidade de Illinois.

Em 1949, Hebb propôs a regra de aprendizagem para a modificação sináptica, que descrevia como a força da conexão sináptica entre dois neurônios poderia ser modificada em função da atividade elétrica desses neurônios.

Em 1951, Minsky e Edmonds criaram o primeiro computador de Redes Neurais: o SNARC[5] (Stochastic Neural-Analog Reinforcement Computer).

No ano de 1957, Frank Rosenblatt divulgou um relatório técnico chamado "The Perceptron: a perceiving and recognizing automaton" no Cornell Aeronautical Laboratory. O projeto contava com o financiamento da Marinha dos Estados Unidos e chamou a atenção do público ao ser mencionado no jornal New York Times em 1958. Nesse relatório, Rosenblatt introduziu o primeiro algoritmo de aprendizado de máquina e o implementou em FORTRAN em um computador IBM 704. Posteriormente, o Perceptron foi construído em hardware, como é o caso do Mark I Perceptron.[6][7]

Em 1960, Widrow e Hoff propuseram o adaline, um modelo de Rede Neural capaz de aprender a produzir uma saída contínua a partir de várias entradas. O adaline foi uma importante contribuição para o desenvolvimento de Redes Neurais capazes de realizar tarefas de regressão

Assim é visto que partir das ideias de McCulloch e Pitts, os estudos em redes neurais evoluíram rapidamente, com contribuições de importantes pesquisadores como Wiener, Von Neumann, Hebb, Minsky, Edmonds, Rosenblatt, Widrow e Hoff, entre outros. Com o avanço da tecnologia computacional, a partir da década de 1980, a área de redes neurais cresceu exponencialmente, tendo aplicações em diversas áreas como reconhecimento de padrões, previsão de séries temporais, processamento de imagens, entre outras. Hoje em dia, uma rede neural é definida como um sistema de processamento de informações que tenta imitar o funcionamento do cérebro humano, através de uma grande quantidade de elementos de processamento simples e interconectados.

Apesar de a contribuição de McCulloch e Pitts ter sido focada na unidade elementar do neurônio artificial, a partir da década de 1940, os estudos em redes neurais rapidamente se expandiram para além disso, abrangendo modelos de múltiplas camadas, algoritmos de treinamento avançados, e arquiteturas cada vez mais complexas. As redes neurais se tornaram uma ferramenta poderosa para lidar com problemas complexos e não-lineares, e ainda hoje são objeto de pesquisa intensa, com novas abordagens e aplicações sendo desenvolvidas continuamente.

As primeiras pesquisas sobre redes neurais datam da década de 1940 com a descoberta do neurônio. Desde então, esta área já passou por períodos de latência e evidencia sendo que, nos últimos anos, consolidou-se com o surgimento de aplicações reais que empregam redes neurais.

Referências

- ↑ a b Kovács, Zsolt László (2002). Redes Neurais Artificiais. [S.l.]: Editora Livraria da Fisica

- ↑ Michael A. Arbib (2002). The Handbook of Brain Theory and Neural Networks (PDF). London, England: [s.n.] ISBN 0262011972

- ↑ McCulloch, Warren S.; Pitts, Walter (1 de dezembro de 1943). «A logical calculus of the ideas immanent in nervous activity». The bulletin of mathematical biophysics (em inglês) (4): 115–133. ISSN 1522-9602. doi:10.1007/BF02478259. Consultado em 23 de março de 2023

- ↑ Wiener, Norbert (1961). Cybernetics; or, Control and communication in the animal and the machine. 2nd edition ed. New York: M.I.T. Press. OCLC 1284210

- ↑ Isaacson, Walter (2014). Os Inovadores (PDF). [S.l.]: lelivros. ISBN 978-85-438-0186-5

- ↑ «Vicente» (PDF). Renato. Perceptrons: 4. 3 de maio de 2017. Consultado em 23 de março de 2023

- ↑ «PRINCIPLES OF NEURODYNAMICS. PERCEPTRONS AND THE THEORY OF BRAIN MECHANISMS» (em inglês). Consultado em 23 de março de 2023